本文來自 Mckinsey Implementing generative AI with speed and safety 的讀後筆記,這是我家的 MA 幫忙找到並介紹給我的,這篇其實出版時間早於金融服務的未來:生成式人工智慧與其運營模式革新。

大意: 生成式人工智慧(gen AI)已成為推動企業創新、成長與提升生產力的關鍵動力。麥肯錫的研究指出,gen AI 不僅有機會為全球經濟增加高達 4.4 兆美元的經濟價值,更能提升所有 AI 技術的影響力 15% 至 40%。然而,如此巨大的潛力自然伴隨著不小的風險,從資料偏差、AI 幻覺、到可能引起的大規模錯誤資訊及對政治和個人福祉的惡意影響,gen AI 的挑戰不容小覷。

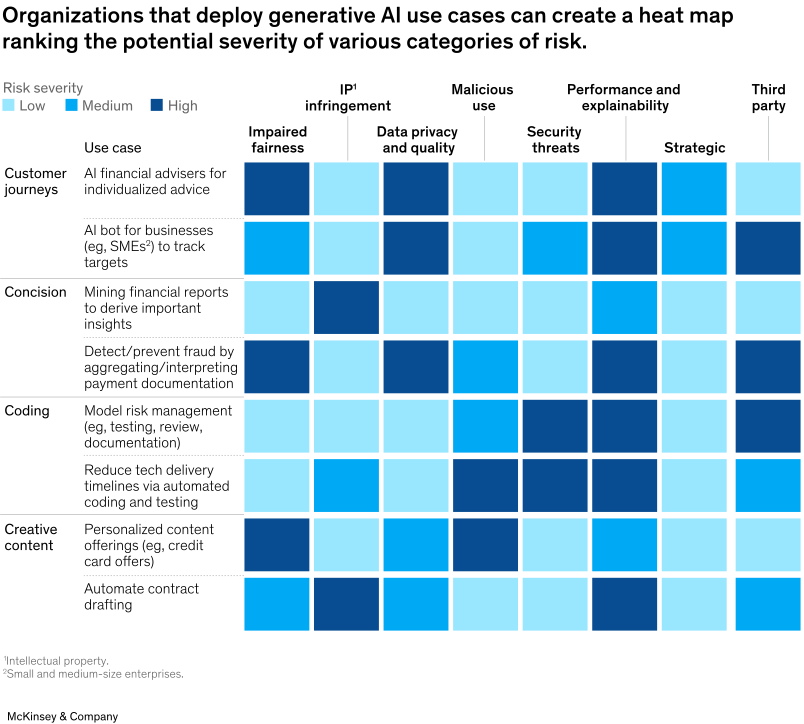

這篇文章深入探討了企業如何在迅速採用 gen AI 的同時,確保安全與負責任地進行。文章建議企業採取四個具體步驟來應對與 gen AI 相關的風險,從了解內部風險暴露(inbound),發展各方面的人工智慧風險觀點,到建立治理結構和運營模型,每一步都旨在為企業提供清晰的路線圖,幫助它們在尚不確定的法規環境中穩健前行。

註:inbound 在這裡指的是即使不部署 gen AI,也可能影響組織的風險

主文摘要:

- 生成式 AI 的轉型潛力與經濟價值

- 生成式 AI 為企業提供轉型機會,能夠在創新、成長和生產力提升等方面產生顯著影響。

- 麥肯錫估計gen AI可能為全球經濟帶來高達 4.4 兆美元的經濟價值,提高所有AI技術影響的 15% 至 40%。

- 風險認識與準備不足

- 許多組織體認到 gen AI 的未來發展機會也正躍躍欲試(63%);但因伴隨重大風險,仍感到自己對於負責任的部署準備不足(91%)。

- 風險包括不準確輸出(含幻覺)、訓練數據偏見,以及對政治和個人福祉的潛在負面影響。

- 負責任與有效風險管理策略

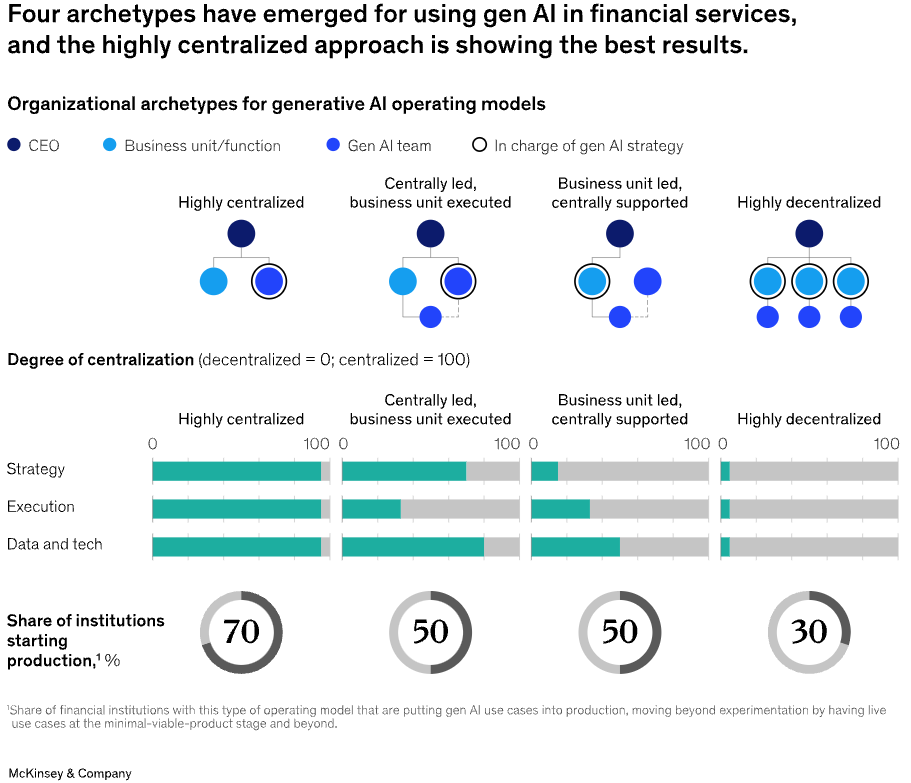

- 文章提議四步驟策略:了解內部的風險暴露、發展全面風險觀點、建立治理結構、嵌入運營模型(這就是上一篇有提到的)。

- 這些策略有助於組織在 AI 監管環境演變時,負責任且有效地捕捉 gen AI 的價值。

- 風險類別與管理

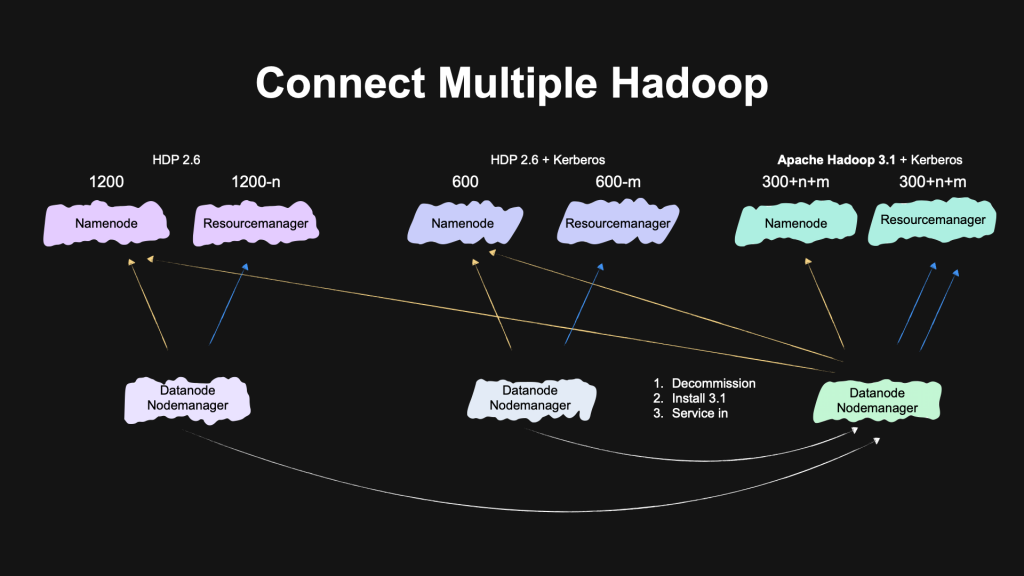

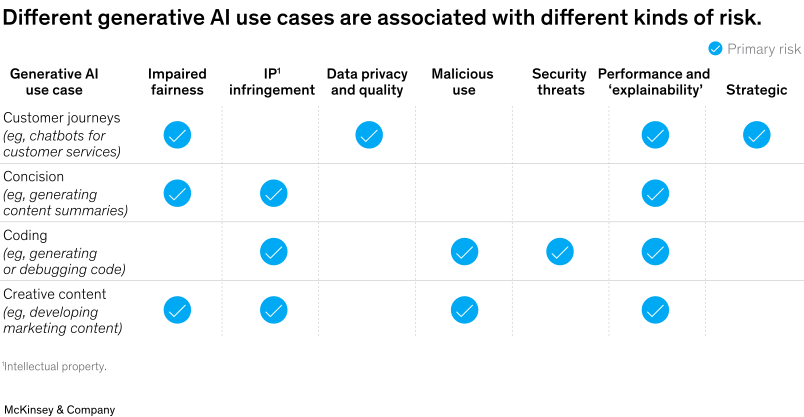

- 將 gen AI 相關風險分為八大類別,包括四個同時也是內部風險源 (inbound) 的安全威脅、第三方風險、惡意使用和侵犯智財權等。

- 強調組織需定期評估風險暴露和更新風險管理策略以適應技術演進。

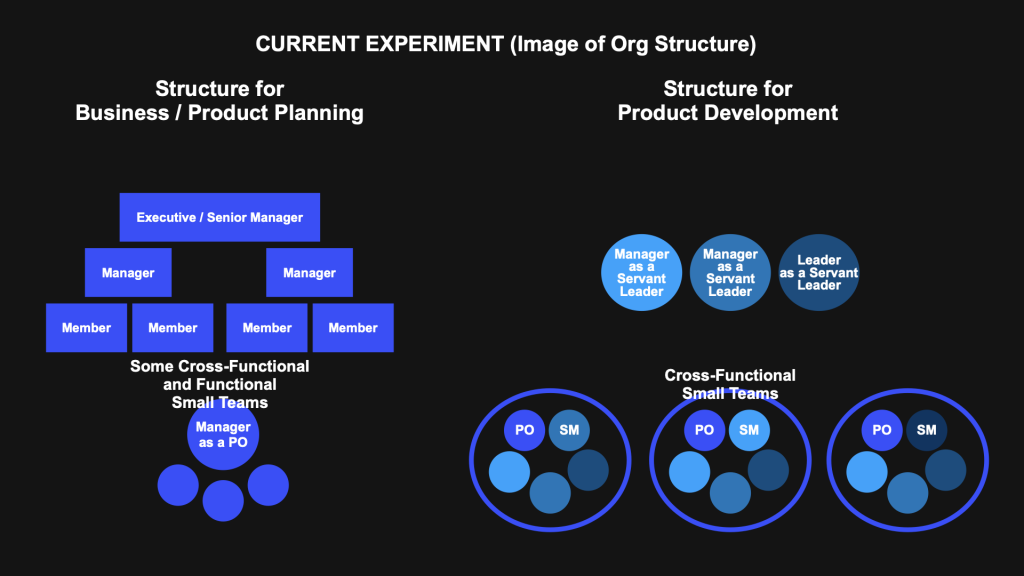

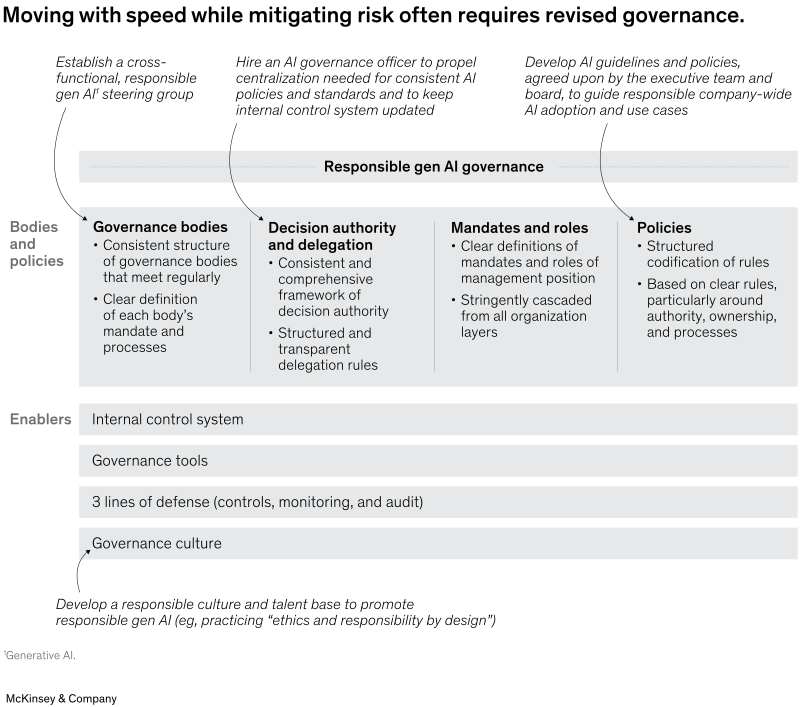

- 通過 AI 治理在速度與風險管理之間取得平衡 (參考圖五)

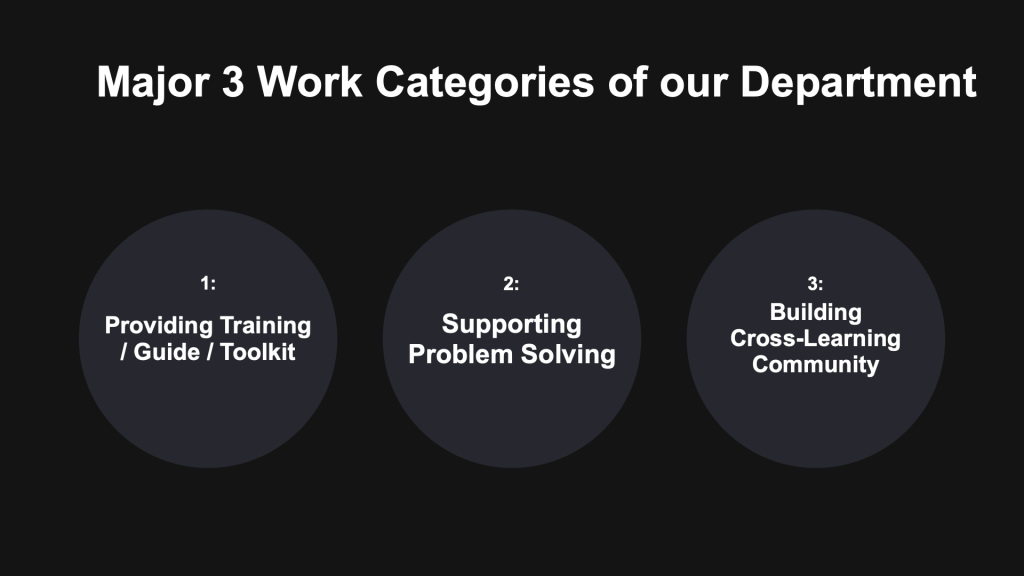

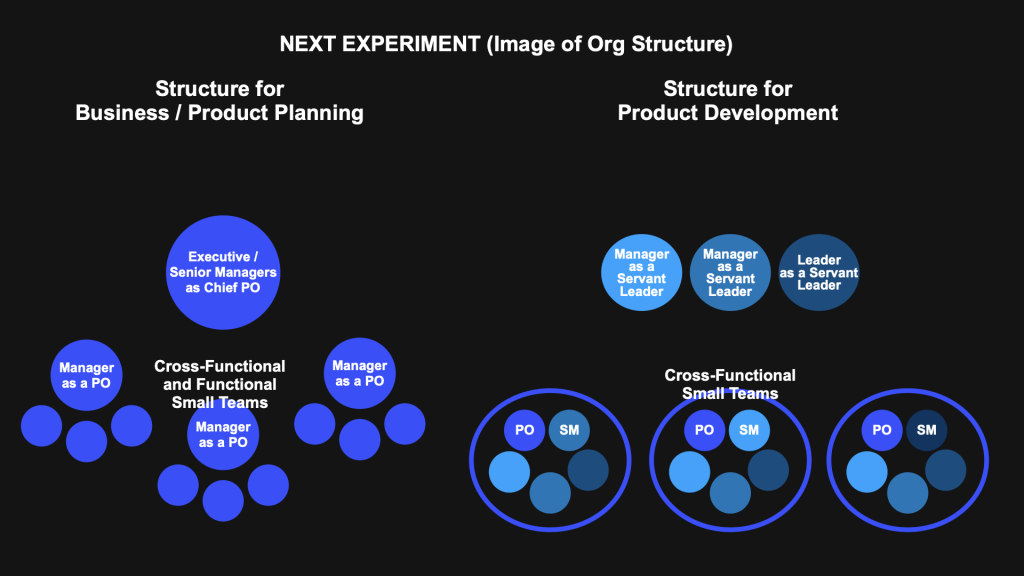

- 一個跨職能、負責 gen AI 發展的小組,至少每月一次會議。

- AI 指導原則和政策:組織應該開發一套由執行團隊和董事會同意的 AI 指導原則和政策。

- AI 人才和文化:對負責任的 AI 的承諾不能僅僅停留在執行層面。相反,它需要貫穿整個組織,將責任、能力建設和意識調整到相關角色對技術的暴露程度。應該開發並推出基本的全組織負責任的 AI 培訓,以促進對內部風險動態的廣泛理解,以及如何安全地與技術互動。

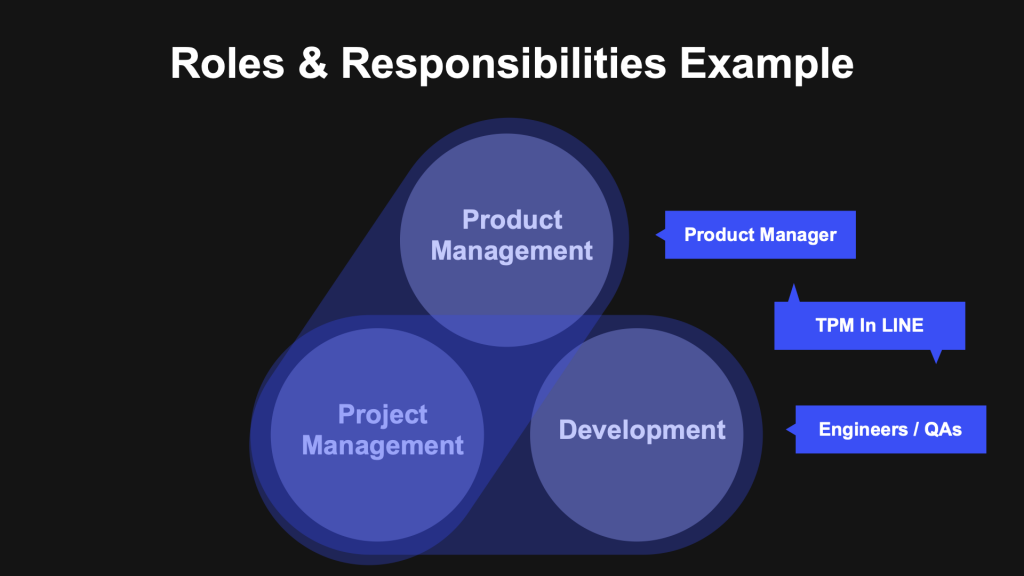

- 實施 gen AI 的關鍵角色與責任

- 四個關鍵角色:設計師、工程師、管理員、和使用者,各自承擔不同職責,推進負責任 AI 使用。

- 建立適當治理結構和人才管理是成功利用 gen AI 的關鍵,幫助組織管理風險並充分掌握技術好處。

結論: 在擁抱gen AI帶來的巨大潛力時,企業必須同時面對與之相伴的風險。麥肯錫的建議提供了一個實用且系統的框架,幫助企業在探索 gen AI 的無限可能性時,仍能保持負責任與謹慎的態度。考慮到潛在的生產力提升,努力可持續且負責任地擴大 gen AI 的規模對於充分發揮其全部好處至關重要。